英特尔发布了其开源渲染降噪器的下一个主要版本——Open Image Denoise 3(OIDN 3),该版本已集成到 Arnold、Blender、Redshift 和 V-Ray 等 CG 应用程序中。

此次更新将引入一个期待已久的功能:支持时域降噪,减少对动画进行降噪时的闪烁问题——并且同时适用于实时和最终质量的工作流程。

这些新功能实际上在去年HPG 大会的一次演讲中就已预览,但并未获得太多媒体报道,因此我们认为值得发布一篇报道。

一个 AI 驱动的、与硬件无关的渲染降噪器

Open Image Denoise 最初于 2019 年发布,是一套“用于光线追踪渲染图像的高性能、高质量降噪滤波器”。

该技术现已广泛集成到DCC 工具和渲染器中,包括 Arnold、Blender、Cinema 4D、Houdini、OctaneRender、Redshift、Unity、Unreal Engine 和 V-Ray。

与 NVIDIA 的 OptiX(同样集成到许多渲染器中)类似,它使用 AI 技术来加速降噪。

但与 OptiX 不同的是,OIDN 并非特定于硬件:虽然它是为英特尔 64 位 CPU 设计的,但它支持“兼容架构”,包括 AMD CPU 和苹果的 M 系列处理器。

自 2023 年Open Image Denoise 2.0 发布以来,OIDN 也可以在 GPU 以及 CPU 上运行,并支持 AMD、英特尔和 NVIDIA 显卡。

目前支持空间降噪,但不支持时域降噪

在演讲中,英特尔首席工程师 Attila Áfra(因其在 OIDN 上的工作而获得科技学院奖)阐述了其当前网络架构的局限性。

他指出的问题包括视觉伪影,例如过度模糊、轻微的色偏和振铃效应,尤其是在光照贴图中。

然而,最大的限制是 OIDN 一次只处理单帧图像,这意味着降噪在时间上是不连贯的:它可能因帧而异。

因此,在对动画而非静态图像进行降噪时,可能会导致明显的闪烁。

OIDN 3:支持时域降噪,适用于实时和最终帧工作流程

OIDN 3 是该架构自最初发布以来的首次重大更新,应该能解决许多视觉伪影问题——更重要的是,它将引入对时域降噪的支持。

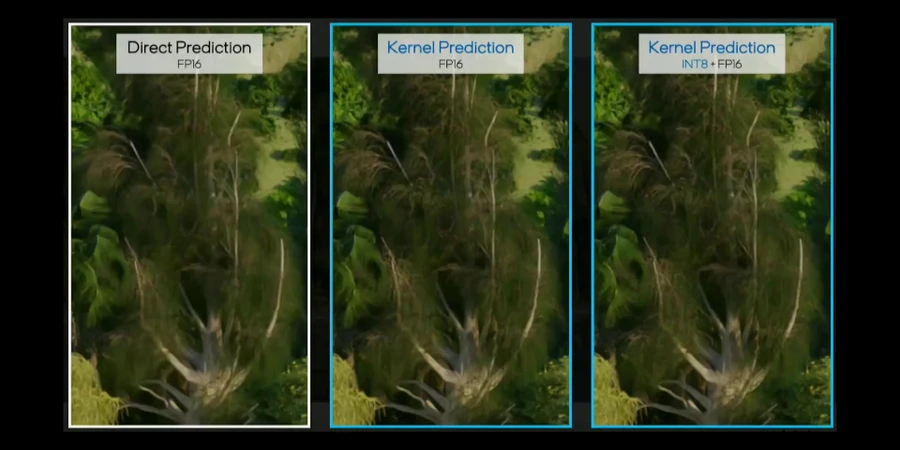

新架构——仍然基于U-Net,但从直接预测转向基于内核预测的降噪——针对实时和最终帧工作提供了不同的网络变体。

实时降噪使用先前已降噪的帧、反向运动矢量和深度数据作为输入。

最终质量降噪还使用未来帧和正向运动矢量作为输入,以提高输出的视觉质量,代价是增加了处理时间。

新架构的其他优点包括可以选择对多个 AOV 使用相同的内核,以及支持超采样。

您可以在本文顶部嵌入的视频中,看到当前架构和新架构在著名的《海洋奇缘》岛屿数据集上的输出对比。

许可、系统要求和发布日期

Open Image Denoise 3 正在开发中。原定于 2025 年底发布,但英特尔告诉我们,现在计划在 2026 年下半年发布。

截至撰写本文时,最新版本仍然是OIDN 2.4.1。

Open Image Denoise 兼容 64 位 Windows、Linux 和 macOS。您可以在OIDN 网站上找到支持的 CPU 和 GPU 架构的完整列表。

源代码和编译版本均在Apache 2.0 许可证下提供。

在 OIDN 网站上阅读更多关于 Open Image Denoise 的信息

(截至撰写本文时,没有更多关于 OIDN 3 的信息)

请通过关注 CG Channel 的 Facebook、Instagram 和 X(原 Twitter) 账号,发表您对此报道的看法。除了能够评论报道外,我们社交媒体账号的关注者还可以看到我们未在网站本身发布的视频,包括最新 VFX 电影、动画、游戏过场动画和动态图形项目的制作花絮。